Im Windschatten der großen Aufmerksamkeit für Künstliche Intelligenz (KI) und dem zunehmend ernsthaften Interesse an Quanten-Computing erlebt auch das Thema High Performance Computing (HPC) seinen zweiten Frühling. Einer der limitierenden Faktoren war hierbei die Zugriffsgeschwindigkeit auf Speichermedien.

Im Bereich des HPC geht es bei der Frage nach den wichtigen Eigenschaften eines parallelen Dateisystems immer um dasselbe: den schnelleren Zugriff auf große und kleine, sequentielle und zufällige Dateien. Früher ging es in erster Linie um die Dateien eines aktuellen Projekts, während man es heute in der auf Daten konzentrierten Ära der KI und der modernen Analytik mit dem gesamten Archiv an Dateien und dem kontinuierlichen Training für ihre Speicherung zu tun hat.

Das grundsätzliche Problem besteht nach wie vor darin, dass die jeweils eingesetzte Software an die Möglichkeiten von Festplattenspeichern gebunden ist, die für kleine, zufällige Lesevorgänge und hohe Zugriffsgeschwindigkeiten von Natur aus insgesamt zu langsam sind. Folglich mussten die Anwender schon immer viel Zeit und Mühe aufwenden, um ihre Anwendungen so umzuschreiben, dass sie weniger zufällige und weniger gleichzeitige Speicherzugriffe ausführen konnten. Dies war auch deshalb notwendig, um die Laufzeit von Anwendungen auf Basis von sich drehenden Festplatten zu verbessern, schränkte aber auch gleichzeitig die Möglichkeiten zur Weiterentwicklung von HPC-Anwendungen durch neue Algorithmen stark ein.

Um was es bei HPC im Prinzip geht

Interessanterweise scheint durch die bisherige Entwicklung im Laufe der Jahre der Eindruck entstanden zu sein, dass es bei HPC in erster Linie um Streaming I/O geht – aber das ist nicht der Fall. Einige der wirklich bedeutenden Fortschritte im HPC werden dadurch ermöglicht, dass die Dateisysteme nicht mehr durch rotierende Festplatten begrenzt sind. Außerdem sollten die Anwender verstehen, dass diese Technologie nicht nur ihre aktuellen Workloads beschleunigt, sondern es ihnen vor allem ermöglicht, sich nicht mehr um zufällige Zugriffsmuster kümmern zu m?ssen.

Das Unternehmen DUG beschreibt die neuen Möglichkeiten nach dem Wechsel von Lustre zu VAST wie folgt: „VAST hat nicht nur die Art und Weise verändert, wie wir Daten speichern – diese Lösung verändert auch unsere Beziehung zu den Daten selbst.“ Diese Aussage fasst den Kern der neuen datenzentrierten Ära bei HPC perfekt zusammen: Hier erweist sich ein schneller Compute-Cluster für moderne Anwendungen nur dann als nützlich, wenn er einen Zugriff auf die richtige Speicherplattform und die entsprechenden Data Services besitzt.

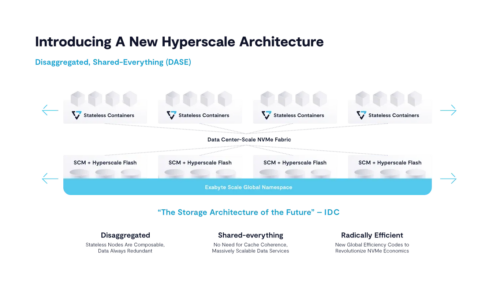

VAST stellt in diesem Zusammenhang eine NFS (Network File System)-basierte Multiprotokoll-Architektur für erschwingliche All-Flash-Systeme in großem Umfang zur Verfügung, die sowohl die Anforderungen an traditionelle HPC-, als auch an neue AI- und Analyse-Anforderungen erfüllen können. Dies führt insgesamt zu einer besseren Handhabung, Performance und Skalierbarkeit der zusammengeführten HPC- und AI-Umgebungen, während gleichzeitig die Komplexität durch Datendienste in Unternehmensqualität, die auf die Bedürfnisse der Benutzer zugeschnitten sind, reduziert wird.

NFS für HPC? Sicherlich ja. Die meisten Administratoren von Speichersystemen für HPC werden bereits irgendwann einmal NFS-Server ausprobiert haben, weil sie angeblich so schön bequem und einfach und von überall aus zugänglich sind. So etwas hat allerdings in der Regel nicht gut funktioniert, was dann zu einem weiteren allgemeinen Missverständnis geführt hat, das lautet: „NFS ist langsam.“ Infolgedessen wandte sich die HPC-Community den weniger bequemen und weniger funktionsreichen parallelen Dateisystemen zu, um die Performance zu steigern.

Aber NFS stellt letztlich nur eine Protokollspezifikation dar. Diese Spezifikation ist ihrem Prinzip nach weder schnell noch langsam. Es ist die konkrete Implementierung des Protokolls hinter der Protokollspezifikation, die das Ergebnis schnell oder langsam macht und die für Scale-up oder Scale-out sorgt.

VAST Data besteht aus einer vollständig skalierbaren Performance-Architektur für erschwingliche Flash-Systeme in großem Maßstab. Und bei VAST legt man nach wie vor großen Wert auf die Performance von NFS. Außerdem haben wir eine Scale-Out-Performance für Systeme mit einer Größe von über 100 Petabyte und einem Durchsatz von über 160 Gigabyte/s für einen einzelnen NFS-Client praktisch vorgeführt.

In einem VAST-System kann ein einzelner Client-Mountpoint entweder mit einem der mehreren Server im System kommunizieren – wobei verschiedene Clients automatisch verschiedenen Servern zugewiesen werden – oder auch parallel mit mehreren Servern durch die NFS-Multipathing-Technologie. In jedem Fall bietet jeder Server in einem VAST-System Zugriff auf den gesamten Namespace, da er mit allen Laufwerken im Backend verbunden ist und somit auch Striping und Erasure Coding über alle Laufwerke hinweg ausführen kann.

Hinzu kommen all die anderen Funktionen, von denen man als Anwender schon immer geträumt hat. Dazu gehören zum Beispiel:

- die Unterstützung für vollständig konsistente Snapshots;

- natives RDMA (IB & RoCE);

- die Möglichkeit, das System problemlos mit verschiedenen physischen Cluster-Netzwerken zu verbinden;

- integrierte Replikation einzelner Unterverzeichnisbäume für Disaster Recovery;

- Mandantenfähigkeit;

- unterbrechungsfreie Upgrades, ohne dass manuelle Befehle auf der Konsole erforderlich sind;

- Kontrolle der Service-Qualität;

- eine Garantie auf die Flash-Laufwerke, die unabhängig von der geschriebenen Datenmenge ist;

- Live-Statistiken für einzelne Benutzer und

- Unterstützung für zusätzliche Protokolle wie SMB und S3 für den Zugriff auf dieselben Daten mit einheitlichen Zugriffsberechtigungen für alle Protokolle.

Mit dem Einsatz von VAST Data erhalten HPC-Benutzer also den Zugang zu den folgenden Funktionen:

- Eine neue Exabyte-fähige Scale-out-Architektur für NFS/SMB/S3/SQL;

- All-Flash-Performance für schnellen, wahlfreien Zugriff auf alle Daten ohne Probleme mit Nachbar-Installationen;

- eine stets online verfügbare HPC-Speicher-Cloud mit einfacher NAS-Verwaltung und unterbrechungsfreien Upgrades;

- Konsolidierung von HPC- und AI/ML-Workloads;

- geringerer Betriebsaufwand und geringere Kosten sowie

- aber am wichtigsten: Forscher und Datenwissenschaftler genießen die Freiheit, moderne Algorithmen auszuführen und zu erfinden, ohne an die Mechanik von traditionellen, sich drehenden Festplatten gebunden zu sein.

Das alles zusammen kann auch als eine adäquate Beschreibung von VAST Data verstanden werden. Aber wir würden dann immer noch nur über die Spitze des Eisbergs, also den wirklichen Funktionsumfang sprechen.

Sven Breuner ist Field CTO International bei VAST Data.

Mehr Details, wie hochleistungsfähige NFS-basierte Infrastrukturen zu HPC passen.